首款支持 Ollama 本地模型的 Claude Code 客户端发布

该项目推出了首个适配 Ollama 本地模型的 Claude Code 客户端。这一工具允许开发者利用本地大模型体验 Claude 级别的代码交互与生成功能。它不仅降低了云端 API 调用成本,更保障了代码隐私,标志着开源模型在工程化落地和...

该项目推出了首个适配 Ollama 本地模型的 Claude Code 客户端。这一工具允许开发者利用本地大模型体验 Claude 级别的代码交互与生成功能。它不仅降低了云端 API 调用成本,更保障了代码隐私,标志着开源模型在工程化落地和...

Ollama 正式实现对 Anthropic API 格式的兼容,这一更新打破了本地开源模型与 Claude 生态之间的壁垒。现在,用户部署在 Ollama 上的本地模型也能像 Claude 官方模型一样,完美支持工具调用和函数调用功能,并...

本地大模型运行工具 Ollama 发布 v0.14.1 版本,宣布在 macOS 和 Linux (CUDA) 系统上提供实验性图像生成模型支持。用户现可通过命令体验首个可用模型 Z-Image-Turbo。虽然目前该模型仅支持 macOS...

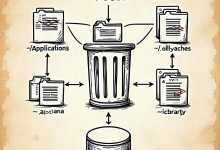

彻底卸载 macOS 上的 Ollama Ollama 在 macOS 上安装时会分散存放文件到多个位置。简单拖拽删除 .app 文件只会移除主程序,下载的模型文件(可能占用几十 GB)和配置文件会留在系统里。 要彻底清理 Ollama,需...

mlvoca平台推出免费LLM API服务,支持DeepSeek R1(1.5b)和TinyLlama模型,无需API密钥即可使用。该API采用Ollama格式,提供POST /api/generate接口,便于开发者快速集成文本生成功能。...

Best local RAG systems for Windows with Ollama support. Tested solutions and community insights for privacy-focused AI deployment.

本文聚焦Windows平台本地运行的最佳RAG(检索增强生成)系统,支持Ollama。用户受限于显存,但出于隐私保护需求,希望在自己电脑上部署高效RAG方案。作者尝试了MaxKB、Openwebui和Cherry Studio,配合嵌入模型...

一位开发者分享了一个月使用ollama+zed的编程体验,认为效果良好。文章质疑了当前流行的付费AI编程服务(如codex、claude code、openrouter等)的性价比,指出这些服务动辄花费数千元,而GitHub Copilot...

本文介绍了在8核心8GB内存的纯CPU服务器环境下,如何选择和部署适合的AI模型。针对中文能力强、幻觉低、逻辑性能优异的需求,文章提供了使用ollama一键拉取模型的具体建议。对于资源有限但仍希望部署高性能AI模型的开发者来说,这是一份实用...

最新评论

Flash版本的响应速度确实提升明显,但我在使用中发现对中文的理解偶尔会出现一些奇怪的错误,不知道是不是普遍现象?

遇到过类似问题,最后发现是网络环境的问题。建议加一个超时重试机制的示例代码。

谢谢分享,我是通过ChatGPT的索引找到这里来的。

十年打磨一个游戏确实罕见,这种专注度在快节奏的游戏行业很难得。从Braid到The Witness,每作都是精品。

快捷键冲突是个很实际的问题,我自己也被这个问题困扰过。最后通过自定义快捷键组合解决了。

会议摘要这个功能很实用,特别是对经常需要参加长会议的人。不过三次免费使用确实有点少了。

硕士背景转AI基础设施,这个路径其实挺常见的。建议多关注底层系统知识,而不只是模型应用层面。

配置虽然简单,但建议补充一下认证和加密的注意事项,避免被中间人攻击。