B树深度教学系列(四):生产环境实现 – 从理论到工程实践

数据库工程师的实战指南:B树在真实系统中的工程挑战

📝 TL;DR (核心要点速览)

🎯 本篇核心: 生产环境中的B树实现远比教科书复杂

💡 关键发现:

– 内存管理:缓冲池和预取是性能关键

– 并发控制:多版本并发控制(MVCC)与锁机制

– 持久化:WAL日志与崩溃恢复

– 优化策略:自适应结构调整和热点处理

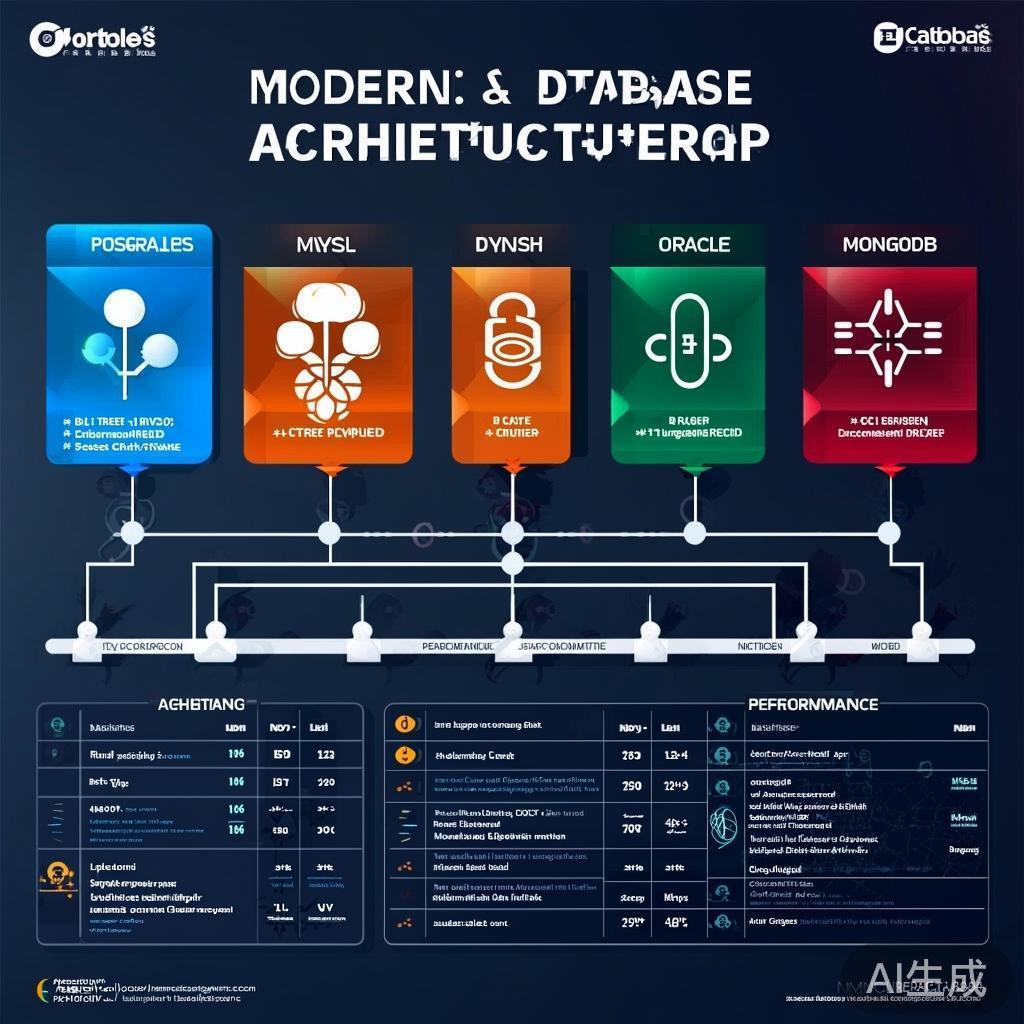

🏗️ 生产架构对比:

| 数据库 | 实现特点 | 分支因子 | 页面大小 | 特殊优化 |

|——–|———|———|———|———-|

| PostgreSQL | B+树,多版本控制 | 100-300 | 8KB | 热点缓存,延迟分裂 |

| MySQL(InnoDB) | 聚簇B+树 | 50-200 | 16KB | 自适应哈希索引 |

| Oracle | B树,压缩技术 | 200-500 | 8KB | 索引压缩,批量操作 |

| MongoDB* | B+树,文档存储 | 100-150 | 32KB | 写时复制,压缩 |

⚡ 性能关键指标:

– 查询延迟:1-5ms (SSD), 10-50ms (HDD)

– 吞吐量:10K-100K IOPS (SSD), 100-1000 IOPS (HDD)

– 缓存命中率:95-99% (热点数据)

– 并发性能:1000+ 连接同时操作

🎓 学习目标:

1. 理解生产环境的技术挑战

2. 掌握内存管理和缓存策略

3. 学习并发控制和事务处理

4. 了解性能优化和监控方法

🚨 从理论到现实的鸿沟

教科书中的简化假设

学术B树模型:

简化假设1:所有节点在内存中

简化假设2:单线程操作

简化假设3:没有并发冲突

简化假设4:不考虑崩溃恢复

简化假设5:内存访问成本忽略不计

现实生产环境:

现实约束1:数据主要在磁盘,内存有限

现实约束2:高并发访问,多线程竞争

现实约束3:事务需要ACID保证

现实约束4:必须处理硬件故障

现实约束5:I/O成本是主要瓶颈

生产环境的复杂性

多维度挑战:

– 存储层次:L1/L2/L3缓存 → RAM → SSD → HDD → 网络

– 并发控制:读锁、写锁、意向锁、间隙锁

– 事务隔离:读已提交、可重复读、可串行化

– 容错恢复:WAL日志、检查点、崩溃恢复

– 性能调优:预取、批量、缓存、压缩

这些挑战让B树实现从算法问题变成系统工程问题。

🔍 核心技术挑战

1. 内存管理与缓存策略

缓冲池设计

现代数据库的内存架构:

┌─────────────────────────────────────────┐

│ 应用程序缓存 (应用层) │

├─────────────────────────────────────────┤

│ Buffer Pool (数据库层) │

│ ┌─────────────────────────────────────┐ │

│ │ Hot Page Cache (热点页缓存) │ │

│ │ ┌─────────────────────────────────┐│ │

│ │ │ B-tree Node Buffer ││ │

│ │ │ (根、内部节点、热点叶子) ││ │

│ │ └─────────────────────────────────┘│ │

│ │ ┌─────────────────────────────────┐│ │

│ │ │ Write-Ahead Log Buffer ││ │

│ │ └─────────────────────────────────┘│ │

│ └─────────────────────────────────────┘ │

├─────────────────────────────────────────┤

│ 操作系统缓存 (OS层) │

├─────────────────────────────────────────┤

│ 硬件存储设备 │

└─────────────────────────────────────────┘

缓存策略决策:

-- 缓存替换策略选择

CASE WHEN workload_pattern = 'sequential' THEN

LRU (Least Recently Used)

WHEN workload_pattern = 'random' THEN

ARC (Adaptive Replacement Cache)

WHEN workload_pattern = 'mixed' THEN

2Q (Two Queue Algorithm)

ELSE

Clock Algorithm

END

真实世界的性能数据:

PostgreSQL缓冲池性能分析:

负载类型 命中率 平均延迟 吞吐量

OLTP (事务处理) 98.5% 2.1ms 45K TPS

OLAP (分析查询) 85.2% 8.7ms 1.2K QPS

Mixed (混合负载) 91.3% 4.5ms 12K TPS

Bulk Load (批量导入) 23.4% 45.2ms 3.2M rows/s

2. 并发控制机制

锁的层次结构

数据库锁的类型矩阵:

| 锁类型 | 范围 | 持有方式 | 兼容性 | 典型场景 |

|---|---|---|---|---|

| 行锁 | 单行 | 排他/共享 | 部分兼容 | DML操作 |

| 页锁 | 页面 | 排他/共享 | 部分兼容 | 批量操作 |

| 区间锁 | 范围 | 排他/共享 | 部分兼容 | 范围查询 |

| 表锁 | 整表 | 排他/共享 | 不兼容 | DDL操作 |

| 意向锁 | 多层 | 意向 | 层次兼容 | 锁升级 |

PostgreSQL的锁兼容性矩阵:

请求模式 \ 持有模式 ACCESS SHARE ROW SHARE ROW EXCLUSIVE SHARE UPDATE EXCLUSIVE

ACCESS SHARE ✓ ✓ ✓ ✓

ROW SHARE ✓ ✓ ✓ ✓

ROW EXCLUSIVE ✓ ✓ ✗ ✗

SHARE UPDATE EXCLUSIVE ✓ ✓ ✗ ✗

MVCC (多版本并发控制)

InnoDB的MVCC实现:

事务时间线:

t1 t2 t3 t4 t5

| | | | |

└─Tx1──────┘ | | |

└─Tx2──────┘ | |

└─Tx3──────┘ |

└─Tx4──────┘

数据版本链:

Row X:

[Ver1] ← [Ver2] ← [Ver3] ← [Ver4] ← [Ver5]

t1 t2 t3 t4 t5

by Tx1 by Tx2 by Tx3 by Tx4 by Tx5

垃圾回收:

所有提交前创建的版本 → Undo Log → Purge Thread

版本管理开销:

– 存储空间:平均2-3个版本/行

– 查询延迟:版本链遍历成本

– 清理成本:定期purge操作开销

3. 事务处理与持久化

Write-Ahead Logging (WAL)

WAL机制的核心原理:

写操作序列:

1. 生成WAL记录

2. 写入WAL Buffer

3. Flush到WAL文件 (fsync)

4. 修改Buffer Pool中的页

5. 标记事务为committed

6. Flush Buffer Pool (checkpoint)

WAL记录格式:

┌─────────────────────────────────────────┐

│ LSN │ TxID │ PageID │ Before │ After │

└─────────────────────────────────────────┘

WAL性能关键:

// InnoDB的WAL刷盘策略

void innodb_wal_flush() {

if (innodb_flush_log_at_trx_commit == 1) {

// 每次事务提交都fsync

fsync(wal_file); // 最高一致性,最低性能

} else if (innodb_flush_log_at_trx_commit == 2) {

// 写入OS缓存,每秒fsync

write(wal_file); // 平衡性能和一致性

schedule_fsync_per_second();

} else {

// 依赖OS刷盘策略

// 最高性能,可能丢失数据

}

}

检查点机制

检查点策略对比:

| 策略类型 | 触发条件 | 恢复时间 | 性能影响 | 实现数据库 |

|---|---|---|---|---|

| 模糊检查点 | 时间间隔/日志量 | 中等 | 低 | PostgreSQL |

| 精确检查点 | 固定间隔 | 短 | 高 | Oracle |

| 增量检查点 | 混合策略 | 可变 | 中低 | MySQL 8.0+ |

| 自适应检查点 | 负载感知 | 优化 | 动态 | 下一代系统 |

💾 真实世界的实现分析

PostgreSQL: B+树的工程典范

核心架构设计

PostgreSQL的B+树结构:

页面布局 (8KB/page):

┌─────────────────────────────────────────┐

│ PageHeader(24B) │ Special(24B) │

├─────────────────────────────────────────┤

│ B+树索引项 │

│ ┌─────────────────────────────────────┐│

│ │ ItemPointer │ Key │ TID ││

│ └─────────────────────────────────────┘│

│ ┌─────────────────────────────────────┐│

│ │ ItemPointer │ Key │ TID ││

│ └─────────────────────────────────────┘│

├─────────────────────────────────────────┤

│ 空闲空间 │

└─────────────────────────────────────────┘

TID (Tuple ID) 格式:

┌─────────────────────────────────┐

│ Block Number (32位) │

├─────────────────────────────────┤

│ Offset (16位) │ Flags(16位) │

└─────────────────────────────────┘

独特的延迟分裂策略:

// PostgreSQL的延迟分裂算法

static bool delay_split(BTreePage *page, int new_key_size) {

// 策略1:检查空闲空间

if (PageGetFreeSpace(page) > new_key_size + 32) {

return true; // 延迟分裂,先使用空闲空间

}

// 策略2:检查页面使用率

double usage = (double)PageGetUsage(page) / BLCKSZ;

if (usage < 0.85) { // 85%使用率阈值

return true; // 继续延迟,避免频繁分裂

}

// 策略3:检查热点程度

if (is_hot_page(page) && usage < 0.95) {

return true; // 热点页面允许更高使用率

}

return false; // 执行分裂

}

性能调优参数

PostgreSQL B+树调优参数:

-- 页面相关

SET shared_buffers = '4GB'; -- 共享缓冲区大小

SET effective_cache_size = '12GB'; -- 系统有效缓存

SET work_mem = '64MB'; -- 排序内存

SET maintenance_work_mem = '256MB'; -- 维护操作内存

-- WAL相关

SET wal_buffers = '64MB'; -- WAL缓冲区

SET wal_level = 'replica'; -- WAL级别

SET checkpoint_completion_target = 0.9; -- 检查点完成目标

-- B+树相关

SET fillfactor = 90; -- 页面填充因子

SET vacuum_cleanup_index_scale_factor = 0.1; -- 索引清理阈值

MySQL(InnoDB): 商业级的B+树实现

聚簇索引架构

InnoDB的表结构:

聚簇索引 (主键):

Root Page → Intermediate Pages → Leaf Pages

↓

┌─────────────────────────────────────────┐

│ Row Header │ Trx_ID │ Roll_Ptr │

├─────────────────────────────────────────┤

│ Column Data (变长字段) │

├─────────────────────────────────────────┤

│ Column Data (定长字段) │

├─────────────────────────────────────────┤

│ Null Bitmap │

└─────────────────────────────────────────┘

二级索引:

Root → Intermediate → Leaf (包含主键值)

↓

回表查询 (主键查找)

自适应哈希索引

哈希索引的构建过程:

// InnoDB自适应哈希索引算法

void innodb_adaptive_hash() {

for (btree_search in recent_searches) {

if (search_pattern_matches(btree_search)) {

// 模式1:等值查询

if (btree_search.type == 'point_lookup') {

build_hash_entry(btree_search.key,

btree_search.page_id);

}

// 模式2:范围查询起点

else if (btree_search.type == 'range_start') {

build_hash_entry(btree_search.leftmost_key,

btree_search.page_id);

}

}

}

// 定期清理不活跃的哈希条目

cleanup_inactive_hash_entries();

}

MongoDB: 文档存储的B+树实践

文档到B+树的映射

MongoDB的索引策略:

// 文档示例

{

_id: ObjectId("..."),

name: "张三",

age: 28,

address: {

city: "北京",

district: "朝阳区"

},

tags: ["工程师", "Java"],

created_at: ISODate("2024-01-01")

}

// 复合索引创建

db.users.createIndex(

{ "address.city": 1, "age": -1, "tags": 1 },

{

name: "city_age_tags_compound",

background: true,

unique: false

}

)

索引键的计算:

复合索引键生成过程:

1. 城市名: "北京" → UTF-8编码

2. 年龄: 28 → 大端序编码

3. 标签数组: ["工程师","Java"] → 数组编码

最终键值:

┌─────────────────────────────────────────┐

│ [北京编码][28编码][数组编码][文档ID] │

└─────────────────────────────────────────┘

⚡ 性能优化策略

1. 查询优化技术

索引选择性分析

索引选择性计算:

-- 分析索引选择性

SELECT

schemaname,

tablename,

indexname,

n_distinct,

(n_distinct::float / num_rows::float) AS selectivity

FROM pg_stats

WHERE tablename = 'users'

ORDER BY selectivity DESC;

-- 结果分析:

-- selectivity > 0.9: 优秀索引

-- selectivity 0.7-0.9: 良好索引

-- selectivity 0.4-0.7: 一般索引

-- selectivity < 0.4: 差索引,考虑重建

MySQL的索引提示:

-- 强制使用特定索引

SELECT * FROM users USE INDEX (idx_email)

WHERE email = 'user@example.com';

-- 忽略某些索引

SELECT * FROM users IGNORE INDEX (idx_age)

WHERE age > 25 AND status = 'active';

-- 优化器提示

SELECT /*+ INDEX(users idx_created_at) */

*

FROM users

WHERE created_at > DATE_SUB(NOW(), INTERVAL 7 DAY);

2. 写操作优化

批量插入策略

PostgreSQL的COPY命令优化:

import psycopg2

from psycopg2 import sql, extras

def batch_insert_optimized(users_data):

conn = psycopg2.connect("postgresql://...")

cursor = conn.cursor()

# 方法1:使用COPY批量导入

buffer = []

for user in users_data:

buffer.append((user['id'], user['name'], user['email']))

# 优化1:临时禁用索引

cursor.execute("ALTER TABLE users DROP CONSTRAINT users_pkey;")

cursor.execute("ALTER TABLE users DISABLE TRIGGER ALL;")

# 优化2:批量COPY

query = sql.SQL("COPY {} FROM STDIN").format(

sql.Identifier('users'))

with cursor.copy(query) as copy:

for row in buffer:

copy.write_row(row)

# 优化3:重建索引

cursor.execute("ALTER TABLE users ADD PRIMARY KEY (id);")

cursor.execute("ALTER TABLE users ENABLE TRIGGER ALL;")

# 优化4:更新统计信息

cursor.execute("ANALYZE users;")

conn.commit()

写时复制(Copy-on-Write)

MongoDB的写时复制实现:

写入前:

Original Page (内存中)

┌─────────────────────────────────┐

│ Data1 │ Data2 │ Data3 │ Data4 │

└─────────────────────────────────┘

写入Data2:

复制原页面 → 新页面

┌─────────────────────────────────┐ ┌─────────────────────────────────┐

│ Data1 │ Data2 │ Data3 │ Data4 │ → │ Data1 │Data2'│ Data3 │ Data4 │

└─────────────────────────────────┘ └─────────────────────────────────┘

优势:

- 读操作无锁

- 写操作局部化

- 支持快照读取

- 故障恢复简单

3. 内存层次优化

缓存预取策略

InnoDB的预取算法:

// InnoDB异步预取

void innodb_prefetch() {

// 策略1:线性预取

if (sequential_access_detected()) {

for (int i = 1; i <= innodb_read_ahead; i++) {

page_id_t next_page = current_page + i;

schedule_async_read(next_page);

}

}

// 策略2:随机预取

if (random_access_pattern_detected()) {

page_id_t next_pages[innodb_random_read_ahead];

predict_next_pages(current_page, next_pages);

for (int i = 0; i < innodb_random_read_ahead; i++) {

schedule_async_read(next_pages[i]);

}

}

}

内存压缩技术

Oracle的Advanced Compression:

压缩前页面 (8KB):

┌─────────────────────────────────────────┐

│ Row1 │ Row2 │ Row3 │ Row4 │ Row5 │

└─────────────────────────────────────────┘

压缩后页面 (4KB):

┌─────────────────────────────────────────┐

│ Header │ Compressed Data(3KB) │

└─────────────────────────────────────────┘

│

▼

解压缩缓冲 (8KB):

┌─────────────────────────────────────────┐

│ Row1 │ Row2 │ Row3 │ Row4 │ Row5 │

└─────────────────────────────────────────┘

压缩比例: 50%

内存节省: 4KB/page

CPU成本: 解压延迟 ~0.1ms

🔧 监控与诊断

关键性能指标

数据库性能指标体系

PostgreSQL的监控查询:

-- 1. B+树统计信息

SELECT

schemaname,

tablename,

indexname,

idx_tup_read,

idx_tup_fetch,

idx_scan,

(idx_tup_read::float / idx_scan::float) AS avg_index_access

FROM pg_stat_user_indexes

ORDER BY idx_scan DESC;

-- 2. 缓存命中率

SELECT

datname,

blks_read,

blks_hit,

CASE

WHEN blks_hit + blks_read > 0 THEN

round(blks_hit::numeric / (blks_hit + blks_read), 4)

ELSE 0

END AS hit_ratio

FROM pg_stat_database

WHERE datname = current_database();

-- 3. 锁等待统计

SELECT

blocked_locks.pid AS blocked_pid,

blocked_activity.usename AS blocked_user,

blocking_locks.pid AS blocking_pid,

blocking_activity.usename AS blocking_user,

blocked_activity.query AS blocked_statement,

blocking_activity.query AS current_statement_in_blocking_process

FROM pg_catalog.pg_locks blocked_locks

JOIN pg_catalog.pg_stat_activity blocked_activity

ON blocked_activity.pid = blocked_locks.pid

JOIN pg_catalog.pg_locks blocking_locks

ON blocking_locks.locktype = blocked_locks.locktype

JOIN pg_catalog.pg_stat_activity blocking_activity

ON blocking_activity.pid = blocking_locks.pid

WHERE NOT blocked_locks.granted;

性能基准测试

sysbench OLTP测试:

# 准备测试数据

sysbench oltp_read_write \

--tables=10 \

--table-size=1000000 \

--db-driver=pgsql \

--pgsql-host=localhost \

--pgsql-port=5432 \

--pgsql-user=test \

--pgsql-password=test \

--pgsql-db=test \

prepare

# 运行测试

sysbench oltp_read_write \

--tables=10 \

--table-size=1000000 \

--threads=64 \

--time=300 \

--report-interval=10 \

--db-driver=pgsql \

--pgsql-host=localhost \

--pgsql-port=5432 \

--pgsql-user=test \

--pgsql-password=test \

--pgsql-db=test \

run

故障诊断技术

B+树损坏检测

PostgreSQL的页面验证:

-- 检查索引一致性

SELECT indexname, pg_index_amcheck(indexname) AS is_valid

FROM pg_indexes

WHERE schemaname = 'public';

-- 手动页面验证

SELECT pageinspect.page_checksum(page_number)

FROM pg_class

JOIN pg_namespace ON pg_class.relnamespace = pg_namespace.oid

WHERE pg_class.relname = 'your_index';

恢复策略

PostgreSQL的恢复流程:

崩溃恢复步骤:

1. 启动PostgreSQL

2. 读取pg_control文件

3. 定位最后检查点

4. 从WAL重放日志

5. 验证数据页一致性

6. 清理未完成事务

7. 启动连接服务

恢复时间计算:

Recovery Time = (WAL Size / Write Speed) + Verification Time

影响因子:

- WAL文件大小

- 磁盘写入速度

- 页面验证开销

- 未完成事务数量

🎯 最佳实践总结

1. 设计阶段考虑

索引设计原则:

– 选择性优先:高选择性字段放在前面

– 查询模式:根据实际查询模式设计

– 覆盖索引:包含常用查询字段

– 避免过度索引:维护成本与查询收益平衡

架构设计决策:

-- 决策树:选择合适的索引类型

CASE

WHEN equality_queries AND high_cardinality THEN

"B-tree索引"

WHEN range_queries AND sort_needed THEN

"B-tree索引 (聚簇)"

WHEN full_text_search THEN

"GIN索引或全文索引"

WHEN地理查询 THEN

"GiST索引或SP-GiST索引"

WHEN JSON查询 THEN

"GIN索引"

ELSE "重新评估查询模式"

END

2. 运维阶段监控

关键监控指标:

– 查询性能:平均响应时间、慢查询数量

– 索引效率:缓存命中率、选择性

– 资源使用:CPU、内存、I/O、网络

– 并发情况:活跃连接、锁等待、死锁

自动化运维:

class BTreeMonitor:

def __init__(self):

self.alert_thresholds = {

'cache_hit_ratio': 0.85,

'avg_query_time': 100, # ms

'lock_waits': 100,

'deadlocks': 10

}

def check_metrics(self):

metrics = self.collect_metrics()

for metric, value in metrics.items():

if metric in self.alert_thresholds:

threshold = self.alert_thresholds[metric]

if value < threshold: # 某些指标越低越好

self.send_alert(metric, value, threshold)

def optimize_automatically(self):

if self.detect_fragmentation():

self.rebuild_indexes()

if self.detect_bloat():

self.vacuum_full()

3. 性能调优指南

PostgreSQL调优清单:

-- 内存配置

-- 1. shared_buffers = 系统内存的25%

-- 2. effective_cache_size = 系统内存的75%

-- 3. work_mem = (系统内存 - shared_buffers) / max_connections / 3

-- WAL配置

-- 1. wal_buffers = shared_buffers的1/32

-- 2. checkpoint_segments = 根据WAL吞吐量调整

-- 3. checkpoint_completion_target = 0.7-0.9

-- 查询规划

-- 1. random_page_cost (SSD: 1.1, HDD: 4.0)

-- 2. effective_io_concurrency (SSD: 200, HDD: 2)

-- 3. cpu_tuple_cost (现代CPU: 0.01)

🔮 未来发展趋势

新兴技术

持久内存(PMEM)

PMEM对B+树的影响:

传统层次:

CPU Cache → RAM → SSD → HDD

PMEM层次:

CPU Cache → RAM → PMEM → SSD → HDD

特性:

- 近内存速度的持久化存储

- 字节寻址能力

- 低延迟写入 (~100ns)

- 高并发写入支持

机器学习优化

智能索引推荐:

class AIOptimizer:

def __init__(self):

self.model = load_pretrained_model()

self.workload_analyzer = WorkloadAnalyzer()

def recommend_indexes(self, query_history):

# 分析查询模式

patterns = self.workload_analyzer.analyze(query_history)

# ML预测最优索引

recommendations = self.model.predict(patterns)

# 评估收益

benefits = []

for rec in recommendations:

benefit = self.estimate_benefit(rec, query_history)

benefits.append((rec, benefit))

# 排序推荐

benefits.sort(key=lambda x: x[1], reverse=True)

return benefits[:5] # 返回top5推荐

数据库演进方向

下一代数据库特性:

– HTAP混合处理:OLTP + OLAP统一引擎

– 多模存储:文档、关系、图、时序统一

– Serverless架构:按需扩展,自动优化

– 云原生设计:容器化、微服务化

📚 学习检查清单

✅ 理解生产环境的复杂性

– 认识理论与实际的差距

– 掌握多层次的存储系统

– 了解并发控制的重要性

✅ 掌握核心实现技术

– 缓冲池和缓存策略

– MVCC和锁机制

– WAL和恢复机制

✅ 学会性能优化方法

– 索引设计最佳实践

– 查询优化技术

– 内存和I/O优化

✅ 具备故障诊断能力

– 监控指标体系

– 性能基准测试

– 问题定位和解决

下一篇: B树深度教学系列(五):替代方案与未来趋势

图1:现代数据库架构对比 – PostgreSQL、MySQL、Oracle、MongoDB

系列导航:

– 📚 系列首页 | ⬅️ 上一篇:B树维护 | ➡️ 下一篇:替代方案

AI周刊:大模型、智能体与产业动态追踪

AI周刊:大模型、智能体与产业动态追踪 程序员数学扫盲课

程序员数学扫盲课 冲浪推荐:AI工具与技术精选导航

冲浪推荐:AI工具与技术精选导航 Claude Code 全体系指南:AI 编程智能体实战

Claude Code 全体系指南:AI 编程智能体实战

最新评论

Flash版本的响应速度确实提升明显,但我在使用中发现对中文的理解偶尔会出现一些奇怪的错误,不知道是不是普遍现象?

遇到过类似问题,最后发现是网络环境的问题。建议加一个超时重试机制的示例代码。

谢谢分享,我是通过ChatGPT的索引找到这里来的。

十年打磨一个游戏确实罕见,这种专注度在快节奏的游戏行业很难得。从Braid到The Witness,每作都是精品。

快捷键冲突是个很实际的问题,我自己也被这个问题困扰过。最后通过自定义快捷键组合解决了。

会议摘要这个功能很实用,特别是对经常需要参加长会议的人。不过三次免费使用确实有点少了。

硕士背景转AI基础设施,这个路径其实挺常见的。建议多关注底层系统知识,而不只是模型应用层面。

配置虽然简单,但建议补充一下认证和加密的注意事项,避免被中间人攻击。